Суперкомпьютер построен благодаря внедрению новых конструкций и технологий. Он является естественным развитием гетерогенной платформы HybriLIT, которая приводит к существенному увеличению производительности как CPU-, так и GPU-компонент платформы (1 Петафлопс с одинарной точностью и 500 Терафлопс с двойной точностью). Модернизированный вычислительный кластер позволяет проводить ресурсоемкие, массивно-параллельные расчеты в решеточной КХД для исследования свойств адронной материи при высокой барионной плотности, высокой температуре и в присутствии сильных электромагнитных полей, качественно повышает оперативность моделирования динамики столкновений релятивистских тяжелых ионов. Суперкомпьютер состоит из двух компонент: на центральных процессорах Intel и графических процессорах Nvidia и позволяет разрабатывать и адаптировать программное обеспечение для мега-проекта NICA на новые вычислительные архитектуры от ключевых игроков рынка HPC – Intel и NVIDIA, создать программно-аппаратную среду на базе HPC и готовить IT-специалистов по всем необходимым направлениям.

Проект нацелен на кардинальное ускорение комплексных теоретических и экспериментальных исследований, проводимых в ОИЯИ, в том числе для комплекса NICA. Публичная презентация нового суперкомпьютера имени Н.Н. Говоруна состоялась 27 марта 2018 г.

О CPU-компоненте на базе процессоров Intel

Эта часть проекта нового суперкомпьютера ОИЯИ реализована при участи специалистов группы компаний РСК и корпорации Intel. РСК разработала обновленное сверхплотное, масштабируемое и энергоэффективное кластерное решение «РСК Торнадо», которое представляет собой набор компонент для создания современных вычислительных систем различного масштаба с 100% жидкостным охлаждением в режиме «горячая вода».

В состав нового суперкомпьютера входит высокоплотное и энергоэффективное решение «РСК Торнадо» на базе серверных технологий Intel с прямым жидкостным охлаждением. Основу вычислительных узлов составили серверные продукты Intel: самые мощные 72-ядерные серверные процессоры Intel® Xeon Phi™ 7290, процессоры семейства Intel® Xeon® Scalable (модели Intel® Xeon® Gold 6154), платы семейств Intel® Server Board S7200AP и Intel® Server Board S2600BP, твердотельные накопители семейства Intel® SSD DC S3520 с подключением по шине SATA в форм-факторе M.2 и новейшие высокоскоростные твердотельные диски Intel® SSD DC P4511 с интерфейсом NVMe емкостью 1 Тбайт.

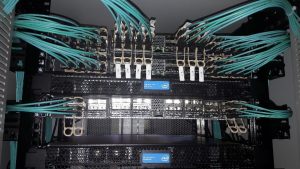

Для высокоскоростной передачи данных между вычислительными узлами в составе суперкомпьютерного комплекса ОИЯИ теперь используется передовая технология коммутации Intel® Omni-Path, обеспечивающая скорость неблокируемой коммутации до 100 Гбит/c, на основе 48-портовых коммутаторов Intel® Omni-Path Edge Switch 100 Series со 100% жидкостным охлаждением, что обеспечивает высокую эффективность работы системы охлаждения в режиме «горячая вода» и наиболее низкую совокупную стоимость владения системой. Применение Intel® Omni-Path Architecture позволит удовлетворить не только текущие потребности ресурсоемких приложений пользователей, но и обеспечить необходимый запас пропускной способности сети на будущее.

Система охлаждения

В Объединенном институте ядерных исследований установлены новые универсальные вычислительные шкафы «РСК Торнадо» с рекордной энергетической плотностью и системой прецизионного жидкостного охлаждения, сбалансированной для постоянной работы с высокотемпературным хладоносителем (до +63 °С на входе в вычислительный шкаф). В соответствии с условиями размещения оборудования для ОИЯИ был выбран оптимальный режим работы вычислительного шкафа при постоянной температуре хладоносителя +45 °С на входе в вычислительные узлы (с пиковым значением до +57 °С).

Работа в режиме «горячая вода» для данного решения позволила применить круглогодичный режим free cooling (24x7x365), используя только сухие градирни, охлаждающие жидкость при помощи окружающего воздуха в любой день года, а также полностью избавиться от фреонового контура и чиллеров. В результате среднегодовой показатель PUE системы, отражающий уровень эффективности использования электроэнергии, составляет менее чем 1,06. То есть на охлаждение расходуется менее 6% всего потребляемого электричества, что является выдающимся результатом для HPC-индустрии.

Технология прямого жидкостного охлаждения РСК обеспечивает прецизионное отведение тепла от сервера, используя охлаждающую пластину, полностью покрывающую всю элементосодержащую поверхность вычислительного узла и в свою очередь охлаждаемую жидкостью. Данный подход обеспечивает наиболее полный теплосъем со всей площади компонентов сервера, исключая локальные перегревы и воздушные карманы, что увеличивает срок службы электронных компонентов, а также повышает отказоустойчивость всего решения.

Для реализации такой системы охлаждения была установлена сухая градирня. Задача сухой градирни состоит в обеспечении охлаждения теплоносителя, занятого в технологическом процессе. Это достигается за счет того, что жидкость, подаваемая в теплообменное устройство, снижает свою температуру под воздействием воздушного потока, забираемого вентиляционной установкой из окружающей среды.

Ввиду особенностей климата в качестве теплоносителя было принято решение использовать раствор незамерзающей жидкости.

Из градирни этиленгликоль попадает в коллектор, а затем в теплообменный агрегат, который поглащает тепловую энергию от воды, которая непосредственно циркулирует через вычислительные узлы суперкомпьютера.

В суперкомпьютер поступает вода, охлажденная до температуры 45 градусов. Пройдя через весь контур в суперкомпьютере, нагретая до 50 градусов вода возвращается в теплообменник, где охлаждается, передавая тепловую энергию в гидравлический контур сухой градирни.

Система охлаждения имеет плавную регулировку производительности, которая позволяет увеличивать или уменьшать мощность системы охлаждения в соответствии с реальной загрузкой. Это позволяет значительно снизить потребление электроэнергии при частичной загрузке.

Система электропитания

Для питания распределительного щита используется входной автомат на 400 А. Вся стойка «РСК Торнадо» потребляет до 100 кВт под полной нагрузкой.

В распределительном щите на градирню используется электроника, которая измеряет температуру охлаждающей жидкости и регулирует обороты вращения вентиляторов.

Программый стек «РСК БазИС» для мониторинга и управления

Высокая доступность, отказоустойчивость и простота использования вычислительных систем, созданных на базе решений РСК для высокопроизводительных вычислений, также обеспечиваются благодаря передовой системе управления и мониторинга на базе ПО «РСК БазИС». Она позволяет осуществлять управление как отдельными узлами, так и всем решением в целом, включая инфраструктурные компоненты. Все элементы комплекса (вычислительные узлы, блоки питания, модули гидрорегулирования и др.) имеют встроенный модуль управления, что обеспечивает широкие возможности для детальной телеметрии и гибкого управления. Конструктив шкафа позволяет заменять вычислительные узлы, блоки питания и элементы гидравлической системы (при условии применения резервирования) в режиме горячей замены без прерывания работоспособности комплекса. Большинство компонентов системы (таких, как вычислительные узлы, блоки питания, сетевые и инфраструктурные компоненты и т.д.) – это программно-определяемые компоненты, позволяющие существенно упростить и ускорить как начальное развертывание, так и обслуживание, и последующую модернизацию системы. Жидкостное охлаждение всех компонентов обеспечивает длительный срок их службы.

О GPU-компоненте на базе процессоров NVIDIA

GPU-компонента суперкомпьютера включает в себя 5 серверов NVIDIA DGX-1. В каждом сервере установлено 8 GPU NVIDIA Tesla V100, основанных на самой современной архитектуре NVIDIA Volta. Кроме того, один сервер NVIDIA DGX-1 имеет 40 960 ядер CUDA, которые по своей вычислительной мощности эквивалентны 800 высокопроизводительным центральным процессорам.

Процессоры Tesla V100 в DGX-1 работают в пять раз быстрее, чем продукты с архитектурой Pascal. Здесь используется целый ряд новых технологий, в том числе шина NVLink 2.0 с пропускной способностью до 300 Гбит/с. В каждом графическом процессоре насчитывается 5120 ядер и более 21 млрд транзисторов, а пропускная способность памяти HBM2 составляет 900 Гбайт/с

Наряду с графическими процессорами в системе установлено два 20-ядерных процессора Intel Xeon E5-2698 v4, работающих на частоте 2,2 ГГц. Сервер оснащен четырьмя твердотельными накопителями емкостью 1,92 Тбайт и одним системным SSD на 400 Гбайт.

Решение от NVIDIA построено на воздушном охлаждении, поэтому стойка с серверами DGX-1 территориально расположена в другом конце помещения машинного зала относительно стоек РСК, которые имеют водяное охлаждение. Охлаждение компонент внутри сервера обеспечивают четыре массивных спаренных вентилятора с частотой вращения до 8000 RPM.

Энергопотребление одного сервера под нагрузкой может достигать 3200 Ватт, т.е. вся стойка, включающая в себя 5 серверов требует около 16 кВатт. Для обеспечения необходимого электропитания в шкаф с серверами установлены два трехфазных распределителя питания APC AP8886 с возможностью подключения до 32 А на каждую фазу. Сами PDU, в свою очередь, запитаны от ИБП Riello Master HP 160 kVA.

В самом сервере установлены четыре блока питания на 1600 W с резервированием N+1. Равномерное распределение нагрузки на блоки питания обеспечивает специальный контроллер.

Связь с остальными узлами кластера осуществляется при помощи высокоскоростной коммутируемой компьютерной сети Infiniband, используемой в высокопроизводительных вычислениях и имеющей очень большую пропускную способность и низкую задержку.

Рисунок 13. Суперкомпьютер «Говорун»

Рисунок 13. Суперкомпьютер «Говорун»