О суперкомпьютере

27 марта 2018 года в рамках сессии Комитета Полномочных Представителей правительств государств-членов ОИЯИ состоялась презентация нового суперкомпьютера, названного в честь Николая Николаевича Говоруна, с именем которого с 1966 года связано развитие информационных технологий в ОИЯИ.

Суперкомпьютер «Говорун» — совместный проект Лаборатории теоретической физики им. Н.Н. Боголюбова и Лаборатории информационных технологий, поддержанный дирекцией ОИЯИ.

Проект нацелен на кардинальные ускорения комплексных теоретических и экспериментальных исследований в области ядерной физики и физики конденсированных сред, проводимых в ОИЯИ, в том числе для комплекса NICA.

Суперкомпьютер является естественным развитием гетерогенной платформы HybriLIT и приведет к существенному увеличению производительности как CPU, так и GPU-компонент платформы. Модернизированный вычислительный кластер позволит проводить ресурсоемкие, массивно-параллельные расчеты в решеточной квантовой хромодинамике для исследования свойств адронной материи при высокой плотности энергии и барионного заряда и в присутствии сверхсильных электромагнитных полей, качественно повысит оперативность моделирования динамики столкновений релятивистских тяжелых ионов, откроет новые возможности для исследования свойств сильно-коррелированных систем в области физики новых материалов, а также позволит разрабатывать и адаптировать программное обеспечение для мега-проекта NICA на новые вычислительные архитектуры от основных лидеров рынка HPC – Intel и NVIDIA, создать программно-аппаратную среду на базе HPC и готовить IT-специалистов по всем необходимым направлениям.

Расширение CPU-компоненты осуществлено на базе специализированной для HPC инженерной инфраструктуре на технологии контактного жидкостного охлаждения, реализуемой российской компанией ЗАО «РСК Технологии». Эта компания является лидером на российском рынке в области HPC-решений на жидкостном охлаждении, которые базируются на ряде собственных уникальных разработок, позволяющих создавать сверхкомпактные и энергоэффективные HPC-системы с высокой вычислительной плотностью. Расширение GPU-компоненты осуществлено на базе вычислительных серверов последнего поколения с графическими ускорителями NVIDIA Volta. Поставку оборудования и пуско-наладочные работы в рамках создания кластера с GPU-компонентой на базе NVIDIA выполнил системный интегратор IBS Platformix.

Технические характеристики

Посмотреть технические характеристики на сайте группы компаний РСК

2,2 PFLOPS Общая пиковая производительность с двойной точностью

10,6 PB системы хранения данных

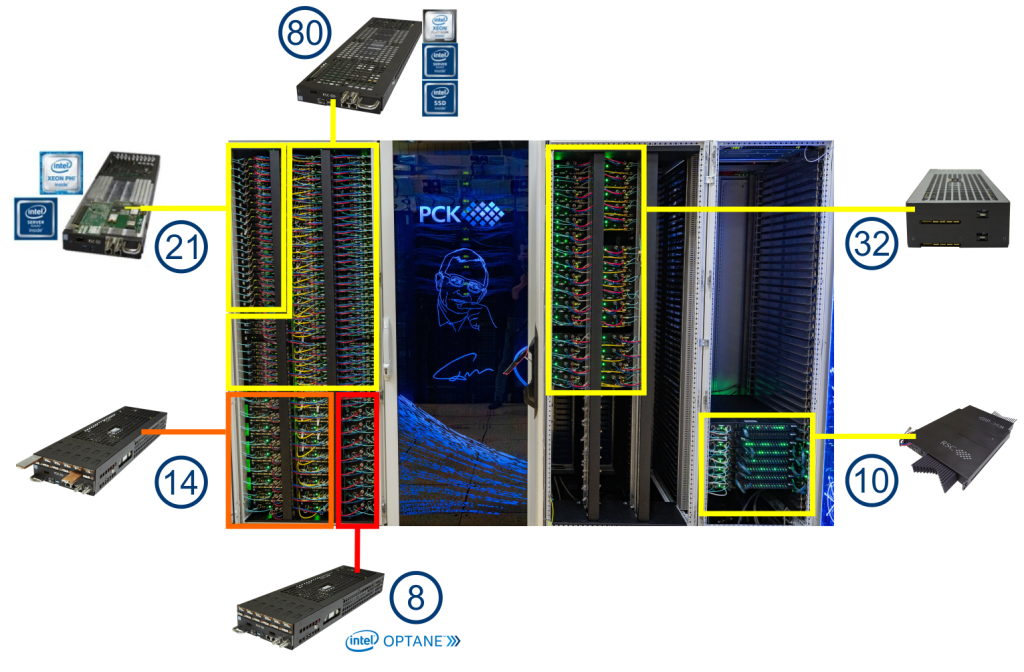

CPU компонента

Компания ЗАО «РСК Технологии» разработала обновленное сверхплотное, масштабируемое и энергоэффективное кластерное решение, которое представляет собой набор компонент для создания современных вычислительных систем различного масштаба с 100% жидкостным охлаждением в режиме «горячая вода». Оно включает высокопроизводительные вычислительные узлы на базе процессоров Intel Xeon Phi и Intel Skylake SP (Scalable Processor) в сочетании с высокоскоростным коммутатором Intel Omni-Path с аналогичным охлаждением «на горячей воде».

800 TFLOPS пиковой производительности с двойной точностью

Характеристики

- Intel® Xeon Phi™ 7190 processors (72 cores)

- Intel® Server Board S7200AP

- Intel® SSD DC S3520 (SATA, M.2)

96GB DDR4 2400 GHz RAM - Intel® Omni-Path 100 Gb/s adapter

- 2x Intel® Xeon® Platinum 8268 processors (24 cores)

- Intel® Server Board S2600BP

- Intel® SSD DC S4510(SATA, M.2),

2x Intel® SSD DC P4511 (NVMe, M.2) 2TB - 192GB DDR4 2933 GHz RAM

- Intel® Omni-Path 100 Gb/s adapter

Посмотреть технические характеристики сервера-лезвия РСК Торнадо TDN511

- 2x Intel Xeon Platinum 8280 processors (28 cores)

- Intel® Server Board S2600BP

- Intel® SSD DC S4510(SATA, M.2),

2x Intel® SSD DC P4511 (NVMe, M.2) 2TB / 4x Intel® (PMem) 450 GB - 192GB DDR4 2933 GHz RAM

- Intel® Omni-Path 100 Gb/s adapter

Посмотреть технические характеристики сервера-лезвия РСК Торнадо TDN511S

- 2x Intel Xeon Platinum 8368Q processors (38 cores)

- Gigabyte Server Board MH62-HD0-R5

- Gigabyte PCIe SSD (NVMe) 256 GB

- 4x Intel® PCIe DC P451 (NVMe) 4 TB

- 2 TB DDR4 3200 GHz RAM

- 2x Intel® Omni-Path 100 Gb/s adapter

Посмотреть технические характеристики сервера-лезвия РСК Торнадо TDN711

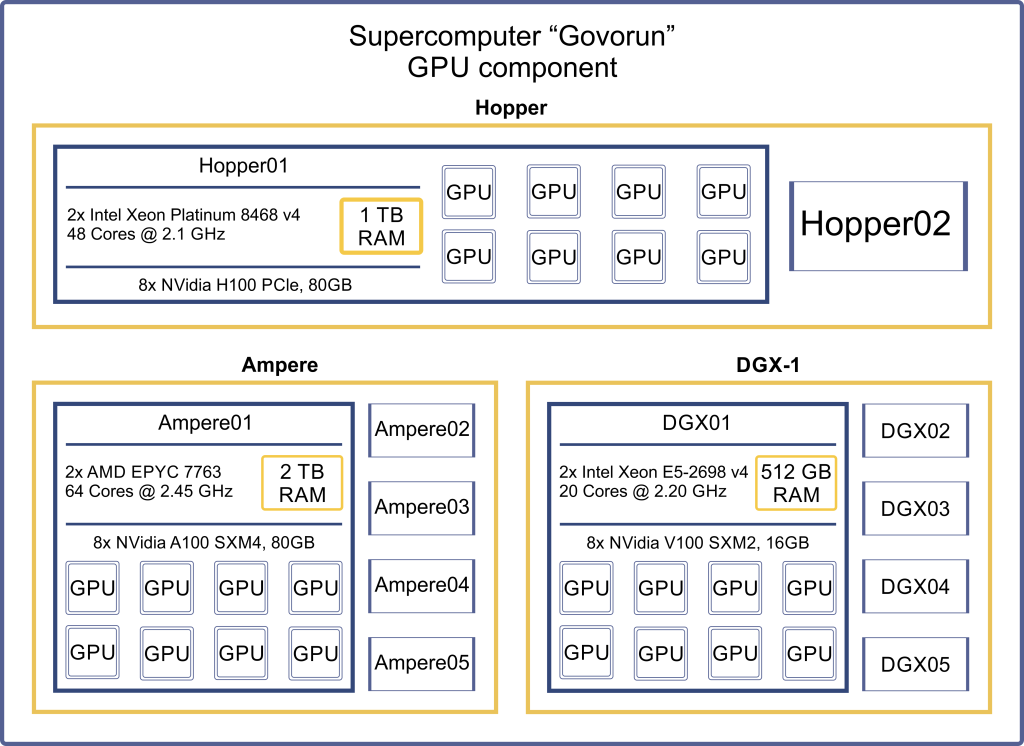

GPU компонента

1,4 PFLOPS пиковой производительности с двойной точностью

58 PFLOPS пиковой производительности с половинной точностью

В состав суперкомпьютера «Говорун» входит 2 сервера RSC Exatream AI, 5 серверов Niagara R4206SG и 5 серверов NVidia DGX-1.

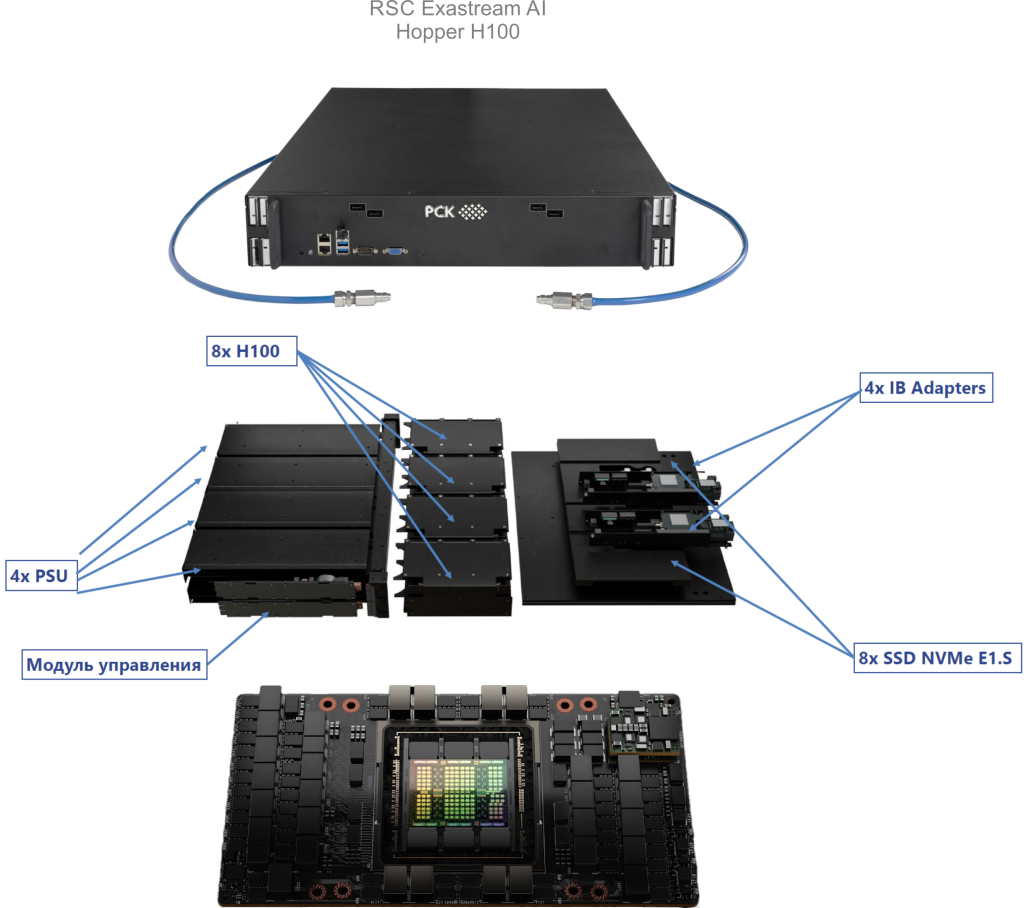

RSC Exatream AI

Сервер RSC Exastream AI — современная модульная аппаратно-программная платформа, предназначенная для выполнения высокопроизводительных вычислений, направленных на решение научно-инженерных задач с помощью технологий искусственного интеллекта. Данная платформа создана специально для Суперкомпьютера «Говорун» с учётом его архитектурно-аппаратных особенностей, в том числе с использованием жидкостного охлаждения компонентов сервера. На суперкомпьютере «Говорун» установлены 2 сервера RSC Exastream AI. В каждом сервере установлено 8 графических ускорителей NVIDIA H100.

Технические характеристики сервера RSC Exastream AI и графического ускорителя Hopper H100:

RSC Exastream AI:

- CPU: 2x Intel Xeon Platinum 8468, 48 Cores @ 2.10 GHz

- RAM: 1 TB DDR5

- NET: 2x Nvidia Mellanox 200 Gbit/sec

- GPU: 8x NVidia H100 SXM5, 80 GB

Hopper H100:

CUDA Cores: 14592

Tensor Cores: 456 (Gen.4)

TMUs: 456

ROPs: 24

SM: 114

L1 cache: 256 KB (per SM)

L2 cache: 50 MB

FP16: 102.4 TFLOPS

FP32: 51.2 TFLOPS

FP64: 25.6 TFLOPS

Deep Learning: 1513 TFLOPS

Посмотреть технические характеристики графического ускорителя Nvidia Hopper H100

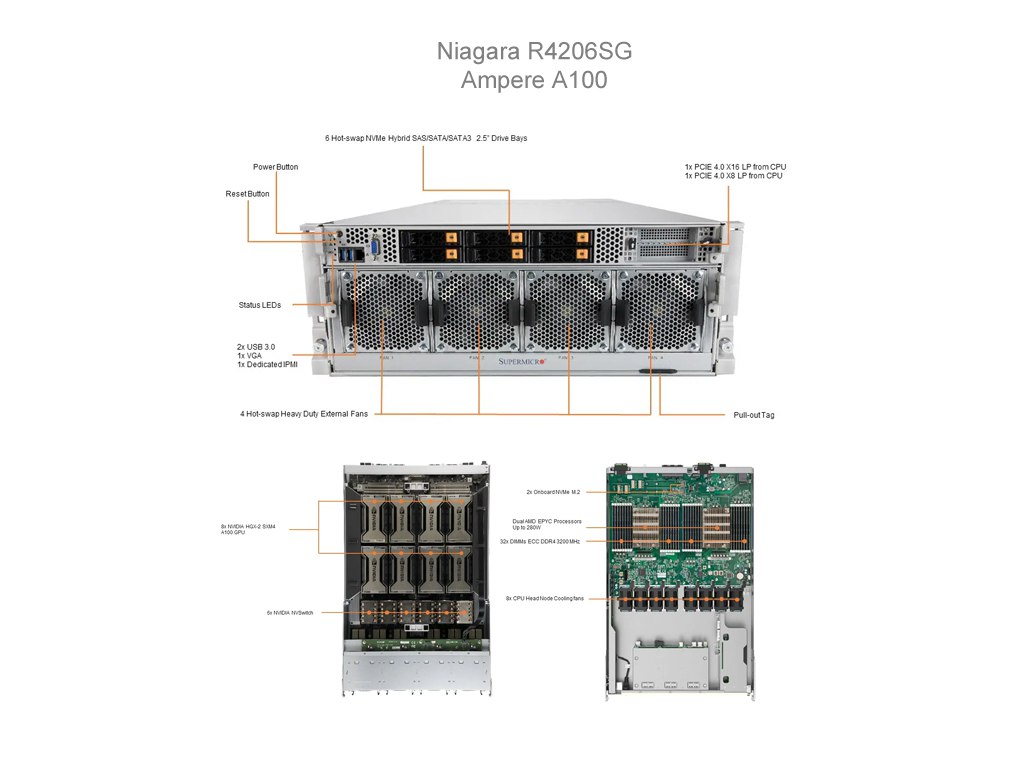

Niagara R4206SG

Сервер Niagara R4206SG — система, предназначенная для использования в центрах обработки данных для решения задач в области искусственного интеллекта, анализа данных и высокопроизводительных вычислений. На суперкомпьютере «Говорун» установлены и сконфигурированы 5 серверов с графическими ускорителями NVIDIA A100 на базе решения компании Niagara модели R4206SG (Supermicro AS -4124GO-NART+). Сервер R4206SG поддерживает до 256 потоков (количество CPU ядер с учётом функции hyperthreading), объём оперативной памяти составляет 2TB. В каждом сервере установлены 8 графических ускорителей NVIDIA A100 со следующими характеристиками: 80GB оперативной памяти, 6192 графических ядер (CUDA ядер), 432 блока текстурных операций (TMU), 160 блоков растровых операций (ROP).

Технические характеристики сервера Niagara R4206SG и графического ускорителя Ampere A100:

- CPU: 2x AMD EPYC 7763, 64 Cores @ 2.45 GH

- RAM: 2 TB

- NET: 2x Nvidia Mellanox 100 Gbit/sec,

2x Supermicro AIOM 100 Gbit/sec (ethernet) - GPU: 8x NVidia A100 SXM4, 80 GB

- CUDA Cores: 6912

- Tensor Cores: 432 (Gen.3)

- TMUs: 320

- ROPs: 160

- SM: 108

- L1 cache: 192 KB (per SM)

- L2 cache: 40 MB

- FP16: 77.97 TFLOPS

- FP32: 19.49 TFLOPS

- FP64: 9.746 TFLOPS

- Deep Learning: 624 TFLOPS

Посмотреть технические характеристики графического ускорителя Nvidia Ampere A100

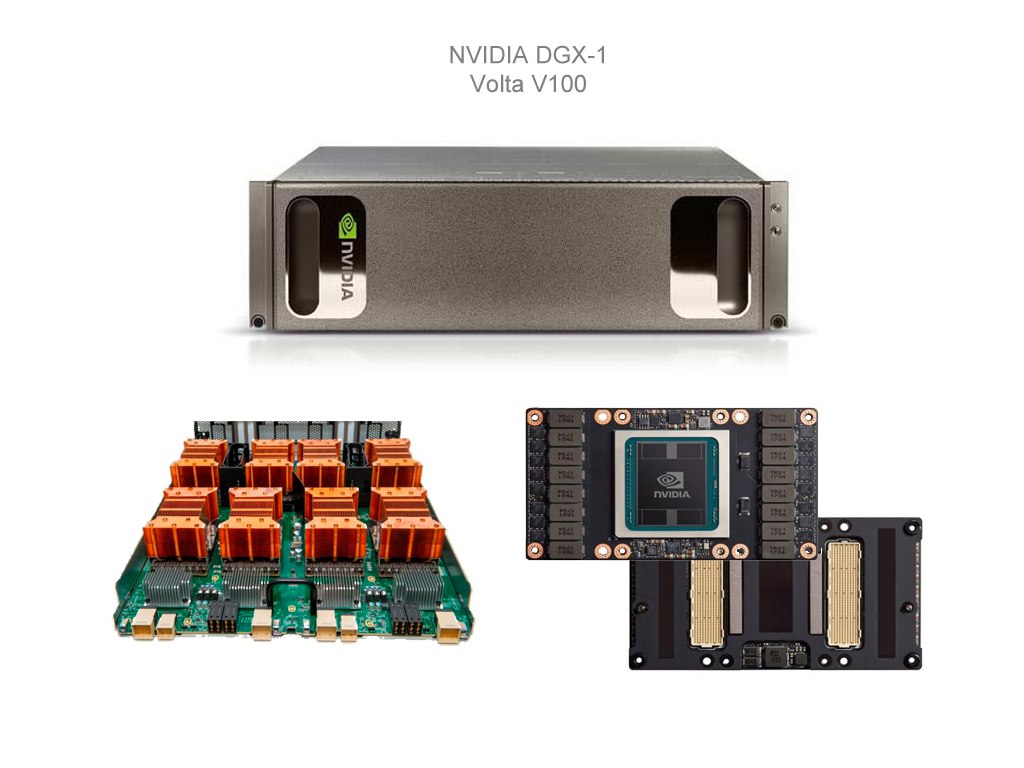

NVidia DGX-1

Программно-аппаратная платформа NVidia DGX-1 — это первая в мире система, разработанная специально для задач глубокого обучения и ускоренного анализа данных в области искусственного интеллекта. Данная система включает в себя 8 графических ускорителей NVidia V100, построенных на основе архитектуры «Volta».

Платформа DGX-1 позволяет обрабатывать и анализировать информацию с производительностью, сопоставимой с 250 серверами x86 архитектуры.

Технические характеристики сервера DGX-1 и графического ускорителя Volta V100:

- CPU: 2x Intel Xeon E5-2698 v4, 20 Cores @ 2.20 GHz

- RAM: 512 GB

- NET: 2x Mellanox InfiniBand 100 Gbit/sec,

1x Mellanox InfiniBand 100 Gbit/sec (ethernet),

1x Intel Omni-Path 100 Gbit/sec

- GPU: 8x NVidia V100 SXM2, 16 GB

- CUDA Cores: 5120

- Tensor Cores: 640 (Gen.1)

- TMUs: 320

- ROPs: 128

- SM: 80

- L1 cache: 128 KB (per SM)

- L2 cache: 6 MB

- FP16: 31.33 TFLOPS

- FP32: 15.67 TFLOPS

- FP64: 7.834 TFLOPS

- Deep Learning: 125.92 TFLOPS

Посмотреть технические характеристики графического ускорителя Nvidia Volta V100

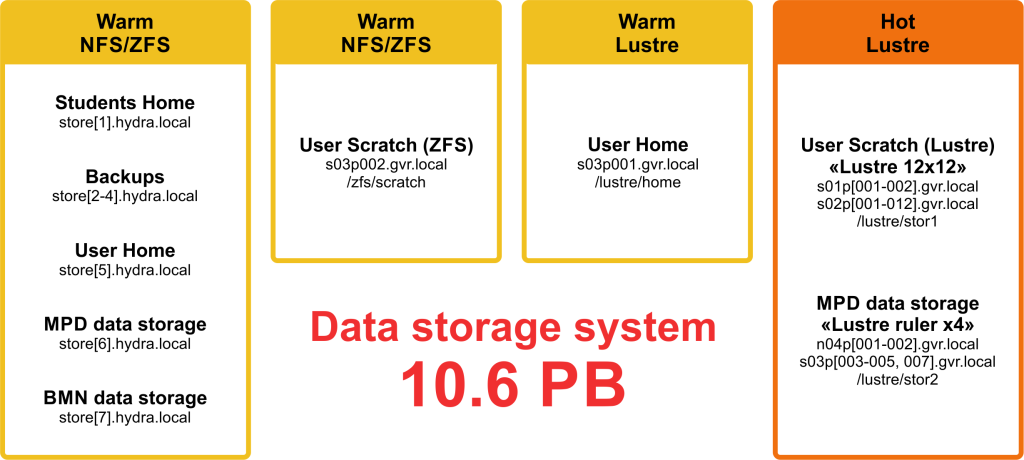

Системы хранения данных

Работа с данными на СК «Говорун»

СК «Говорун» содержит сетевую систему хранения РСК Storage on-Demand, представляющую собой единую централизованно управляемую систему и имеет несколько уровней хранения данных — очень горячие данные, горячие данные и теплые данные.

- Система хранения очень горячих данных создана на основе четырёх серверов-лезвий РСК Торнадо TDN511S. В каждый сервер установлено 12 высокоскоростных твёрдотельных дисков с низкой латентностью Intel® Optane™ SSD DC P4801X 375GB M.2 Series с технологией Intel® Memory Drive Technology (IMDT), что позволяет получить 4,2 ТБ для очень горячих данных на каждом сервере.

- Система хранения горячих и теплых данных состоит из статической системы хранения с параллельной файловой системой Lustre, созданной на основе 14 серверов-лезвий РСК Торнадо TDN511S, и динамической РСК Storage on-Demand на 84 серверах-лезвиях РСК Торнадо TDN511 с поддержкой параллельной файловой системы Lustre.

Для быстрого доступа к метаданным файловой системы Lustre без задержек используются твёрдотельные диски с низкой латентностью Intel® Optane™ SSD DC P4801X 375GB M.2 Series. Для хранения горячих данных Lustre используются твердотельные диски Intel® SSD DC P4511 (NVMe, M.2).

В состав модуля сетевой инфраструктуры входят коммуникационная и транспортная сеть, сеть управления и мониторинга и сеть управления заданиями. Сервера NVIDIA DGX-1 соединены между собой коммуникационной и транспортной сетью на базе технологии InfiniBand 100 Gbps, а связь этой компоненты с CPU модулем осуществляется посредством Intel OmniPath 100 Gbps. 3.5. Коммуникационная и транспортная сеть CPU модуля использует технологию Intel OmniPath 100 Гбит/с и построена по топологии «утолщенного дерева» на базе 48-портовых коммутаторов Intel OmniPath Edge 100 Series с полным жидкостным охлаждением.

Не менее важной частью архитектуры СК «Говорун» является программное обеспечение управления суперкомпьютером РСК БазИС. РСК БазИС использует операционную систему CentOS Linux версии 7.8 на всех вычислительных узлах (ВУ) и выполняет следующие функции:

- осуществление мониторинга вычислительных узлов с функционалом аварийного отключения в случае обнаружения критических неисправностей (таких как перегрев ВУ);

- осуществляет сбор показателей функционирования компонент коммуникационной и транспортной сети;

- осуществляет сбор показателей производительности вычислительных узлов – загруженность процессоров и оперативной памяти;

- хранение отслеживаемых показателей с возможностью просмотра статистики за заданный интервал времени (не менее одного года);

- сбор показания интегрального индикатора состояния ВУ и отображение на геометрическом виде стойки вычислителя;

- отображение статуса системы обнаружения протечек по датчикам контроля влажности на вычислительных узлах и отображение на геометрическом виде стойки вычислителя;

- отображение эффективности использования выделенных ресурсов через планировщика SLURM пользователю кластера для определенной задачи в виде показателя средней загрузки выделенных пользователем ЦП (%);

- отображение доступности ВУ по вычислительной сети и сети управления на геометрическом стойки вычислителя.