Д.В. Беляков, А.А. Кокорев, Д.В. Подгайный

ЛИТ, ОИЯИ

Файловая система Lustre включает в себя службу управления Lustre (MGS), хранилище метаданных (MDS) и службу объектного хранения (OSS). Файловая система Lustre может обслуживать сетевые подключения по протоколам – RDMA (InfiniBand, Omni-Path) и TCP/IP.

В архитектуре файловой системы Lustre заложена файловая система ZFS, гарантирующая стабильное и продуктивное распоряжение ресурсами диска. ZFS выделяется на фоне классических файловых систем благодаря своей структуре, сфокусированной на сохранности информации и удобстве администрирования.

Важной чертой ZFS является ее способ фиксации данных: она всегда создает новые блоки для записи, не затрагивая старые. Это позволяет избежать трудностей, возникающих при неполной записи информации, что способно привести к сбою файловой системы. Благодаря такому решению ZFS[4] не требует ведения журнала, необходимого для большинства других файловых систем, что делает ее устройство проще и увеличивает скорость работы.

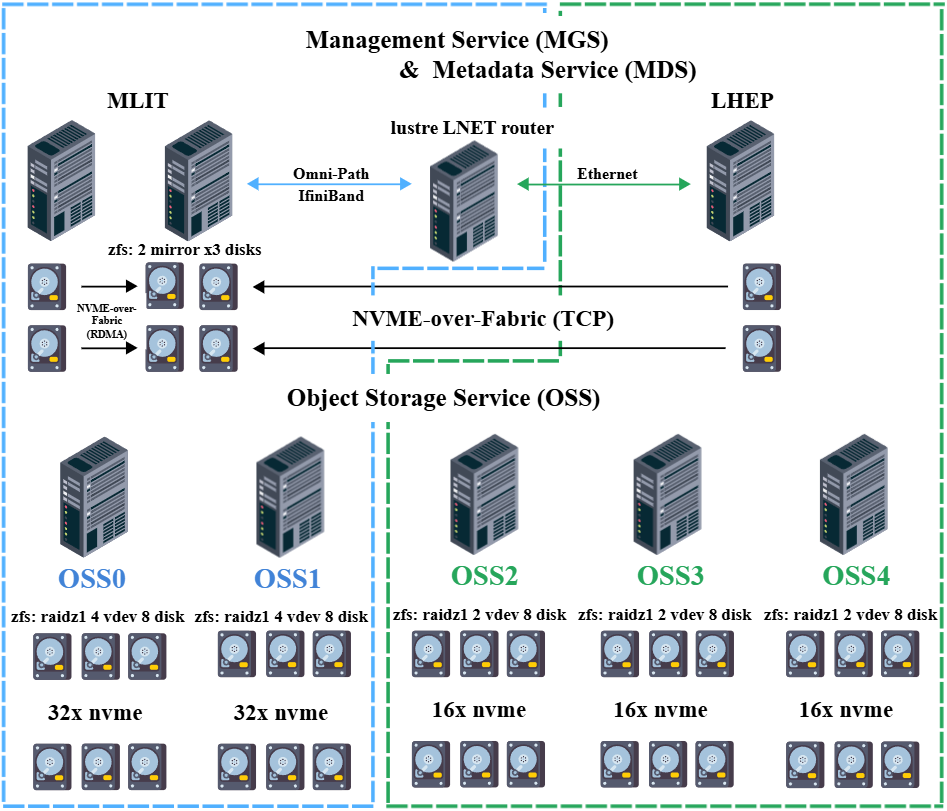

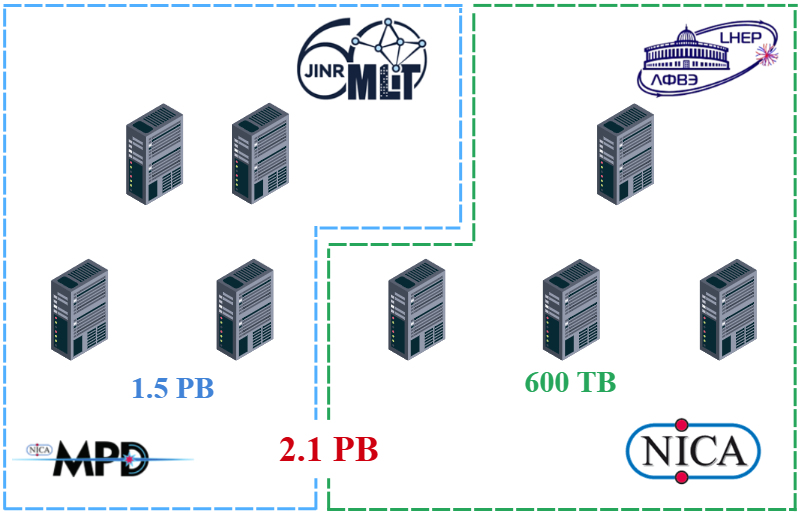

Для реализации проекта по внедрению и конфигурации распределенной файловой системы Lustre между двумя кластерами ОИЯИ, расположенными в ЛИТ и ЛФВЭ[2], с каждой из площадок были предоставлены выделенные серверные ресурсы. На этих вычислительных мощностях была создана распределенная параллельная файловая система Lustre. Архитектура Lustre[3], основанная на принципе распределенности, гарантирует повышенную доступность и устойчивость к отказам, используя программный пакет Pacemaker/Corosync[5]. Это обеспечивает непрерывность работы системы даже при неисправности одного из элементов, благодаря задействованию резервных компонентов.

Рис. 1. Схема реализации файловой системы Lustre

На рисунке 1 представлена схема распределенной файловой системы Lustre в которой было задействовано серверного оборудования.

Со стороны ЛИТ выделено серверное оборудование входящих в состав суперкомпьютера «Говорун»[1], два сервера для управления файловой системой Lustre и два сервера хранения, которые имеют следующие технические характеристики:

- Два сервера управления РСК Торнадо TDN711[6] — 2 процессора Intel(R) Xeon(R) Platinum 8268 CPU @ 2.90GHz, 96 core, 192 Gb оперативной памяти, Intel Omni-path 200 GiB/sec.

- Два сервера хранения РСК Торнадо TDN551 AFS[7] — 2 процессора Intel(R) Xeon(R) Gold 6248R CPU 3.00GHz, 48 core, 376 Gb оперативной памяти, Intel Omni-path 200 GiB/sec, 32х твердотельных накопителя Intel 30,73 TB форм-фактор E1.L общей емкостью порядка 1 PB.

- На площадке ЛФВЭ было выделено серверное оборудование, сервер для управления файловой системой Lustre, которые имеют следующие технические характеристики:

- Сервер управления Supermicro — 2 процессора Intel(R) Xeon(R) CPU E5-2690 v4 @ 2.60GHz, 56 core, 256 Gb оперативной памяти, Mellanox 200 GiB/sec.

- Три сервера хранения Supermicro — 2 процессора Intel(R) Xeon(R) Gold 6230R CPU 2.10GHz, 52 core, 786 Gb оперативной памяти, Mellanox 200 GiB/sec, 16х твердотельных накопителя Intel 15,36 TB форм-фактор E1.L общей емкостью 245,76 ТB.

Методика тестирования производительности файловой системы Lustre

Для анализа работы и определения производительности файловой системы Lustre были использованы тесты с применением инструментария IOR[8]. IOR задействует MPI для организации процессов чтения и записи, которые осуществляются параллельно на большом количестве вычислительных серверов.

Тестирование выполнялось, придерживаясь следующей схемы: для приложения IOR был подготовлен файл конфигурации, который разместили на главном вычислительном сервере. В этом файле был указан список всех вычислительных узлов, участвующих в работе IOR. Чтобы обеспечить параллельный ввод-вывод данных, IOR использует библиотеку OpenMPI[9], построенную на базе стандарта MPI. При компиляции IOR из его исходного кода был установлен набор разработчика openmpi-devel. Тесты запускались из интерфейса командной строки с помощью команды mpirun.

Результаты тестирования файловой системы Lustre

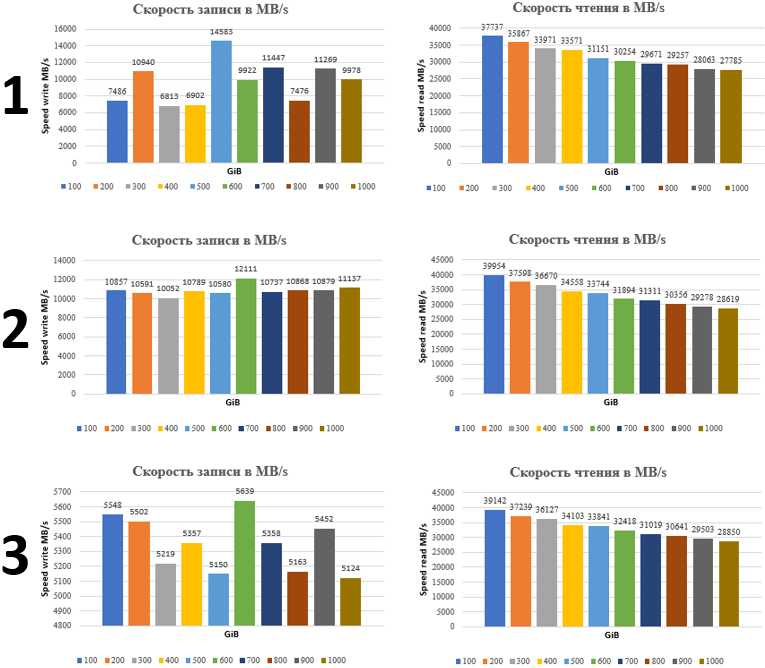

Тестирование проводилось в три этапа инструментарием IOR который использует программный пакет OpenMPI.

Рис. 2. Результаты тестирования файловой системы Lustre.

- 1 этап включал в себя тестирование ФС когда запись и чтение происходило на все сервера хранения т.е. на сервера ЛИТ и ЛФВЭ . Из графиков видно, что максимальная скорость записи составила 14583 MB/s а минимальная 6813 MB/s.

- 2 этап включал в себя тестирование ФС когда запись и чтение происходило на все сервера хранения ЛИТ. Из графиков видно, что скорость записи данных на сегмент ЛИТ происходит быстрее и стабильней чем в остальных двух этапов тестирования.

- 3 этап включал в себя тестирование ФС когда запись и чтение происходило на все сервера хранения расположенные на площадке ЛФВЭ. И из графиков видно, что запись данных происходить медленнее чем на графиках выше.

Скорость чтения при выполнении трех этапов тестирования почти ничем не отличается.

Рис. 3. Схема дискового пространства файловой системы Lustre.

В итоге, развернутая распределенная файловая система Lustre обеспечила формирование унифицированного хранилища информации, к которому можно получить доступ из любого местоположения. Это существенно облегчило процесс обмена данными у пользователей. Данное файловой хранилище использует коллаборация MPD на мегасайнс-проекта NICA для моделирования данных.

Результаты работы доложены:

- На 11-ой международной конференции «Распределённые вычисления и грид-технологии в науке и образовании» (GRID-2025), 7-11 июля 2025 г., ОИЯИ, Дубна, Россия[10].

- Суперкомпьютерные дни в России 2024 (RSD 2024), Москва, Россия[11].

Литература

[1] Super computer Govorun. Cсылка: http://hlit.jinr.ru/supercomputer_govorun/.

[2] Laboratory of high energy physics. Cсылка: https://lhep.jinr.ru/.

[3] Lustre file system. Cсылка: https://www.lustre.org/.

[4] ZFS file system. Cсылка: https://zfsonlinux.org/.

[5] Pacemaker/Corosync. Cсылка: https://clusterlabs.org/projects/.

[6] RSK Tornado TDN711. Cсылка: https://rscgroup.ru/product/rsc-tornado-servers/tdn711/.

[7] RSK Tornado TDN551, AFS. Cсылка: https://rscgroup.ru/product/rsc-tornado-servers/tornado-afs/.

[8] IOR. Cсылка: https://github.com/hpc/ior.

[9] OpenMPI. Cсылка: https://www.open-mpi.org/.

[10] Распределённая параллельная файловая система Lustre для обработки и анализа данных мегасайенс-проекта NICA / Д.В. Беляков, А.А. Кокорев, Д.В. Подгайный // Секционный доклад, 11-ая международная конференция «Распределённые вычисления и грид-технологии в науке и образовании» (GRID-2025), 8 июля 2025 г., ОИЯИ, Дубна, Россия. Cсылка: https://indico.jinr.ru/event/5170/contributions/31770/.

[11] Распределённая параллельная файловая система Lustre для обработки и анализа данных экспериментов физики высоких энергий, Суперкомпьютерные дни в России 2024 (RSD 2024), , Москва, Россия. Cсылка: https://2024.russianscdays.org/workshop/HPCCenters.